एक भाषा मॉडल के प्रशिक्षण के लिए डेटासेट

Latest Technology, (लेटेस्ट टेक न्यूज़) Gadget (गैजेट्स) …

भाषा मॉडल एक गणितीय मॉडल है जो मानव भाषा को उसकी शब्दावली पर संभाव्यता वितरण के रूप में वर्णित करता है। किसी भाषा को मॉडल करने के लिए गहन शिक्षण नेटवर्क को प्रशिक्षित करने के लिए, आपको शब्दावली की पहचान करने और इसकी संभाव्यता वितरण को सीखने की आवश्यकता है। आप शून्य से मॉडल नहीं बना सकते. आपको अपने मॉडल से सीखने के लिए एक डेटासेट की आवश्यकता है।

इस लेख में, आप भाषा मॉडल को प्रशिक्षित करने के लिए उपयोग किए जाने वाले डेटासेट और सार्वजनिक रिपॉजिटरी से सामान्य डेटासेट कैसे प्राप्त करें, इसके बारे में जानेंगे।

आएँ शुरू करें।

एक भाषा मॉडल के प्रशिक्षण के लिए डेटासेट

द्वारा तसवीर डैन वी. कुछ अधिकार सुरक्षित.

भाषा मॉडल के प्रशिक्षण के लिए एक अच्छा डेटासेट

एक अच्छे भाषा मॉडल को पूर्वाग्रहों और त्रुटियों से मुक्त होकर सही भाषा का उपयोग सीखना चाहिए। प्रोग्रामिंग भाषाओं के विपरीत, मानव भाषाओं में औपचारिक व्याकरण और वाक्यविन्यास का अभाव होता है। वे लगातार विकसित होते रहते हैं, जिससे सभी भाषा विविधताओं को सूचीबद्ध करना असंभव हो जाता है। इसलिए, मॉडल को नियमों से तैयार करने के बजाय डेटासेट से प्रशिक्षित किया जाना चाहिए।

भाषा मॉडलिंग के लिए डेटासेट स्थापित करना चुनौतीपूर्ण है। आपको एक बड़े, विविध डेटासेट की आवश्यकता है जो भाषा की बारीकियों का प्रतिनिधित्व करता हो। साथ ही, यह उच्च गुणवत्ता वाला, सही भाषा उपयोग प्रस्तुत करने वाला होना चाहिए। आदर्श रूप से, टाइपो, व्याकरण संबंधी त्रुटियों और गैर-भाषा सामग्री जैसे प्रतीकों या HTML टैग जैसे शोर को दूर करने के लिए डेटासेट को मैन्युअल रूप से संपादित और साफ किया जाना चाहिए।

शुरुआत से ऐसा डेटासेट बनाना महंगा है, लेकिन कई उच्च-गुणवत्ता वाले डेटासेट मुफ्त में उपलब्ध हैं। सामान्य डेटासेट में शामिल हैं:

- सामान्य क्रॉल. विविध सामग्री के साथ 9.5 पेटाबाइट से अधिक का एक विशाल, लगातार अद्यतन डेटासेट। इसका उपयोग GPT-3, Llama और T5 सहित प्रमुख मॉडलों द्वारा किया जाता है। हालाँकि, चूंकि इसे वेब से स्रोत किया गया है, इसमें पक्षपातपूर्ण और आपत्तिजनक सामग्री के साथ-साथ निम्न-गुणवत्ता और डुप्लिकेट सामग्री भी शामिल है। इसे उपयोगी बनाने के लिए कठोर सफाई और फ़िल्टरिंग की आवश्यकता होती है।

- C4 (विशाल स्वच्छ क्रॉल कॉर्पस). वेब से 750GB डेटासेट निकाला गया। कॉमन क्रॉल के विपरीत, यह डेटासेट पहले से साफ और फ़िल्टर किया जाता है, जिससे इसका उपयोग करना आसान हो जाता है। फिर भी, संभावित पूर्वाग्रहों और त्रुटियों की अपेक्षा करें। इस डेटासेट पर T5 मॉडल को प्रशिक्षित किया गया था।

- विकिपीडिया. अकेले अंग्रेजी सामग्री लगभग 19 जीबी है। यह विशाल है फिर भी प्रबंधनीय है। यह विकिपीडिया मानकों के अनुसार अच्छी तरह से संरचित, संरचित और संपादित है। हालाँकि यह उच्च तथ्यात्मक सटीकता के साथ सामान्य ज्ञान की एक विस्तृत श्रृंखला को शामिल करता है, इसकी विश्वकोश शैली और स्वर बहुत विशिष्ट हैं। अकेले इस डेटासेट पर प्रशिक्षण के कारण मॉडल इस शैली में ओवरफिट हो सकते हैं।

- विकिटेक्स्ट. सत्यापित अच्छे और चुनिंदा विकिपीडिया लेखों से प्राप्त एक डेटासेट। दो संस्करण मौजूद हैं: WikiText-2 (सैकड़ों लेखों से 2 मिलियन शब्द) और WikiText-103 (28,000 लेखों से 100 मिलियन शब्द)।

- बुककोर्पस. दीर्घ-रूप, सामग्री-समृद्ध, उच्च-गुणवत्ता वाले पुस्तक पाठों का कुछ जीबी डेटासेट। सुसंगत कहानी कहने और लंबी दूरी की निर्भरता सीखने के लिए उपयोगी। हालाँकि, यह कॉपीराइट मुद्दों और सामाजिक पूर्वाग्रहों को जानता है।

- ढेर. बुककॉर्पस सहित कई स्रोतों से 825GB क्यूरेटेड डेटासेट। यह विभिन्न पाठ्य शैलियों (किताबें, लेख, स्रोत कोड और अकादमिक पेपर) को मिश्रित करता है, जो बहु-विषयक तर्क के लिए डिज़ाइन किया गया व्यापक सामयिक कवरेज प्रदान करता है। हालाँकि, इस विविधता के परिणामस्वरूप परिवर्तनशील गुणवत्ता, डुप्लिकेट सामग्री और असंगत लेखन शैलियाँ होती हैं।

डेटासेट प्राप्त करना

आप इन डेटासेट को ऑनलाइन खोज सकते हैं और उन्हें संपीड़ित फ़ाइलों के रूप में डाउनलोड कर सकते हैं। हालाँकि, आपको प्रत्येक डेटासेट के प्रारूप को समझने और उन्हें पढ़ने के लिए कस्टम कोड लिखने की आवश्यकता होगी।

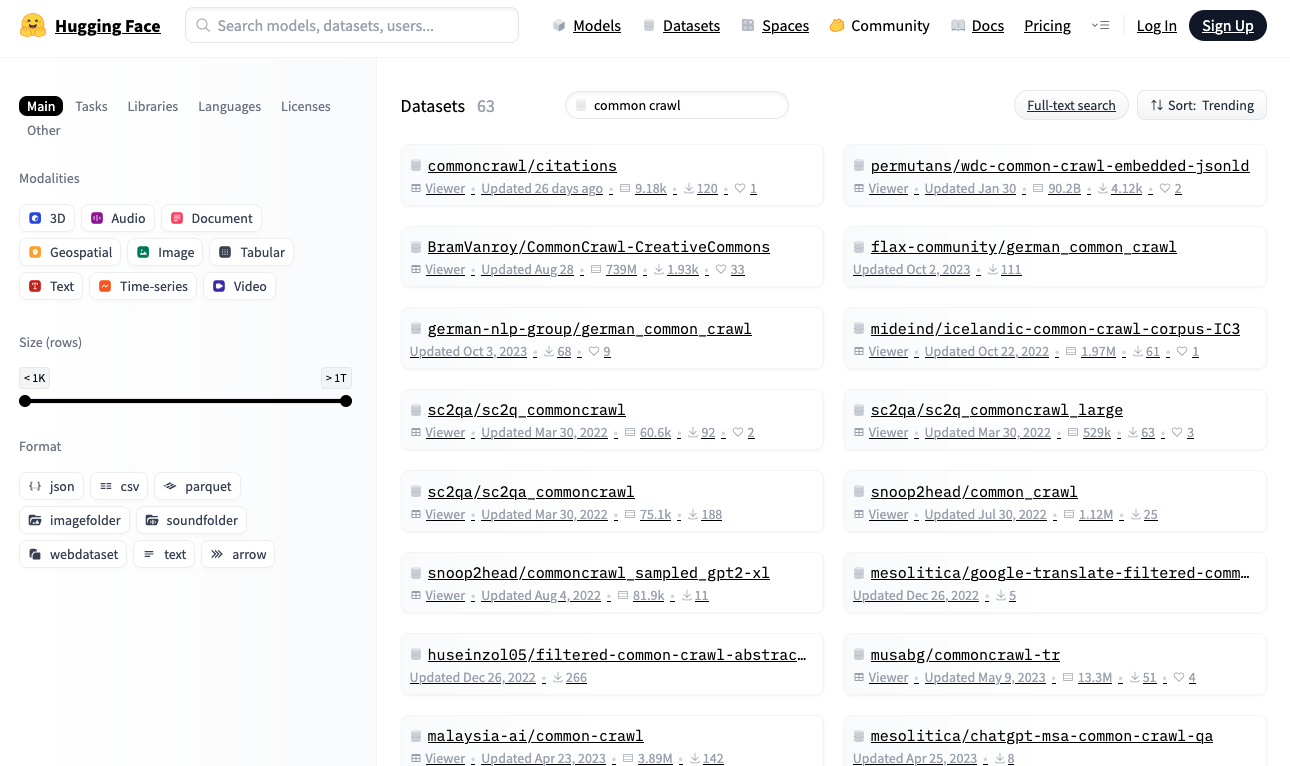

वैकल्पिक रूप से, हगिंग फेस रिपॉजिटरी में डेटासेट खोजें https://huggingface.co/datasets. यह रिपॉजिटरी एक पायथन लाइब्रेरी प्रदान करती है जो आपको मानकीकृत प्रारूप का उपयोग करके वास्तविक समय में डेटासेट डाउनलोड करने और पढ़ने की सुविधा देती है।

हगिंग फेस डेटासेट रिपॉजिटरी

आइए हगिंग फेस से विकीटेक्स्ट-2 डेटासेट डाउनलोड करें, जो भाषा मॉडल बनाने के लिए उपयुक्त सबसे छोटे डेटासेट में से एक है:

आयात यादृच्छिक से डेटासेट आयात लोड_डेटासेट डाटासेट = लोड_डेटासेट(“विकीपाठ”, “विकीटेक्स्ट-2-रॉ-v1”) छपाई(एफ“डेटासेट का आकार: {len(डेटासेट)}”) # कुछ नमूने प्रिंट करें एन = 5 जबकि एन > 0: आईडीएक्स = यादृच्छिक.randint(0, लेन(डाटासेट)–1) मूलपाठ = डाटासेट(आईडीएक्स)(“मूलपाठ”).पट्टी() अगर मूलपाठ और नहीं मूलपाठ.इसके साथ आरंभ होता है(“=”): छपाई(एफ“{idx}: {पाठ}”) एन -= 1 |

आउटपुट इस तरह दिख सकता है:

डेटासेट का आकार: 36718 31776: थ्री फोर्क्स के ऊपर मिसौरी का हेडवाटर ऊपर की ओर की तुलना में कहीं अधिक दूर तक फैला हुआ है… 29504: अल्लाह शब्द के क्षेत्रीय रूप बुतपरस्त और ईसाई पूर्व @-@ दोनों में पाए जाते हैं … 19866: पोकिरी (अंग्रेजी: Rogue) 2006 की भारतीय तेलुगु @-@ भाषा की एक्शन फिल्म है, … 27397: मिनेसोटा में पहली आटा मिल 1823 में फोर्ट स्नेलिंग में बनाई गई थी… 10523: संगीत उद्योग ने कैरी की सफलता पर ध्यान दिया। उन्होंने दो पुरस्कार जीते… |

यदि आपने पहले से नहीं किया है, तो हगिंग फेस डेटासेट लाइब्रेरी स्थापित करें:

जब आप इस कोड को पहली बार चलाते हैं, load_dataset() डेटासेट को आपकी स्थानीय मशीन पर डाउनलोड करता है। सुनिश्चित करें कि आपके पास पर्याप्त डिस्क स्थान है, विशेष रूप से बड़े डेटासेट के लिए। डिफ़ॉल्ट रूप से, डेटासेट डाउनलोड किए जाते हैं ~/.cache/huggingface/datasets.

सभी हगिंग फेस डेटासेट एक मानक प्रारूप का पालन करते हैं। dataset ऑब्जेक्ट एक पुनरावर्तनीय है, प्रत्येक आइटम एक शब्दकोश के रूप में है। भाषा मॉडल प्रशिक्षण के लिए, डेटासेट में आमतौर पर टेक्स्ट स्ट्रिंग होते हैं। इस डेटासेट में, टेक्स्ट को के अंतर्गत संग्रहीत किया जाता है "text" चाबी।

उपरोक्त कोड डेटासेट से कुछ तत्वों का नमूना लेता है। आपको अलग-अलग लंबाई की सादा पाठ स्ट्रिंगें दिखाई देंगी।

डेटासेट को पोस्ट-प्रोसेस करना

किसी भाषा मॉडल को प्रशिक्षित करने से पहले, आप डेटा को साफ़ करने के लिए डेटासेट को पोस्ट-प्रोसेस करना चाह सकते हैं। इसमें पाठ को पुन: स्वरूपित करना (लंबी पंक्तियों को क्लिप करना, एकाधिक रिक्त स्थान को एकल रिक्त स्थान से बदलना), गैर-भाषा सामग्री (HTML टैग, प्रतीक) को हटाना, और अवांछित वर्णों को हटाना (विराम चिह्न के आसपास अतिरिक्त रिक्त स्थान) शामिल हैं। विशिष्ट प्रसंस्करण डेटासेट पर निर्भर करता है और आप मॉडल में टेक्स्ट कैसे प्रस्तुत करना चाहते हैं।

उदाहरण के लिए, यदि एक छोटे BERT-शैली मॉडल को प्रशिक्षित किया जाता है जो केवल छोटे अक्षरों को संभालता है, तो आप शब्दावली का आकार कम कर सकते हैं और टोकननाइज़र को सरल बना सकते हैं। यहां एक जनरेटर फ़ंक्शन है जो पोस्ट-प्रोसेस्ड टेक्स्ट प्रदान करता है:

डीईएफ़ wikitext2_डेटासेट(): डाटासेट = लोड_डेटासेट(“विकीपाठ”, “विकीटेक्स्ट-2-रॉ-v1”) के लिए वस्तु में डाटासेट: मूलपाठ = वस्तु(“मूलपाठ”).पट्टी() अगर नहीं मूलपाठ या मूलपाठ.इसके साथ आरंभ होता है(“=”): जारी रखना # खाली पंक्तियों या हेडर पंक्तियों को छोड़ें उपज मूलपाठ.निचला() # टेक्स्ट का लोअरकेस संस्करण तैयार करें |

एक अच्छा पोस्ट-प्रोसेसिंग फ़ंक्शन बनाना एक कला है। इसे मॉडल को बेहतर सीखने में मदद करने के लिए डेटासेट के सिग्नल-टू-शोर अनुपात में सुधार करना चाहिए, जबकि एक प्रशिक्षित मॉडल के सामने आने वाले अप्रत्याशित इनपुट प्रारूपों को संभालने की क्षमता को संरक्षित करना चाहिए।

आगे की पढाई

नीचे कुछ संसाधन दिए गए हैं जो आपको उपयोगी लग सकते हैं:

सारांश

इस लेख में, आपने भाषा मॉडल को प्रशिक्षित करने के लिए उपयोग किए जाने वाले डेटासेट और सार्वजनिक रिपॉजिटरी से सामान्य डेटासेट कैसे प्राप्त करें, इसके बारे में सीखा। यह डेटासेट अन्वेषण के लिए केवल एक प्रारंभिक बिंदु है। डेटासेट लोडिंग गति को अनुकूलित करने के लिए मौजूदा पुस्तकालयों और उपकरणों का लाभ उठाने पर विचार करें ताकि यह आपकी प्रशिक्षण प्रक्रिया में बाधा न बने।

Latest Technology, (लेटेस्ट टेक न्यूज़) Gadget (गैजेट्स) …

Source link